Ядра и память

Хотя сегодня мы смотрим на GF100 с точки зрения игровой производительности, NVIDIA стремилась создать максимально универсальный чип, отлично подходящий для GPGPU расчетов. В свете этого архитектура Fermi, изначально создаваемая с большим вниманием к неграфическим вычислениям, отличается от предшественников.

Теперь все вычисления на уровне ядер соответствуют спецификациям IEEE. Речь идет о стандарте IEEE-754 2008 для вычислений с плавающей запятой (то же самое реализовано и в RV870/HD 5870) и полной поддержке 32-битной точности для целых чисел. Например, ранее умножение 32-битных целых приходилось эмулировать, аппаратно производилось лишь 24-битное умножение. Теперь все подобные проблемы, приводящие в определенных случаях к заметной потери производительности и, потенциально, даже к недостоверным результатам, остались в прошлом. Добавили и новые инструкции, такие как одновременное сложение и умножение (Fused Multiply Add, FMA). Проведенные оптимизации преследовали цель создания чипа, соответствующего всем индустриальным стандартам точности; требовалось уйти от различных вспомогательных способов при вычислениях, чтобы при любых операциях результат соответствовал ожиданиям. Что касается нецелочисленной математики удвоенной точности (FP64), производительность здесь скачкообразно возросла. В пике скорость исполнения инструкций по работе с 64-битными FP отныне лишь вполовину меньше 32-битных FP, хотя ранее наблюдалось восьмикратное падение (показатель AMD для FP64 — 1/5 от FP32).

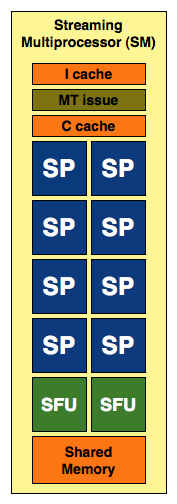

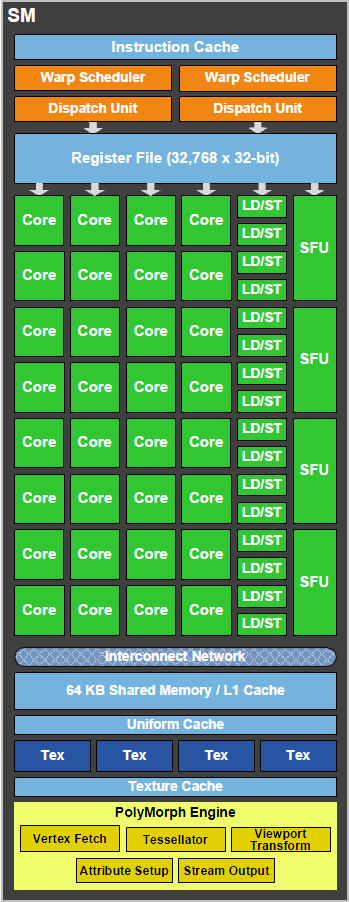

Как и ранее, SM включают в себя не одни лишь ядра. Для трансцендентной математики и интерполяции все так же используются отдельные SFU. В GT200 SM был наделен двумя SFU, в GF100 их теперь четыре. Интересно, что баланс между общей вычислительной мощностью и возможностями SFU изменился — четырехкратный прирост ядер в SM дополняется лишь двукратным ростом количества блоков специального назначения.

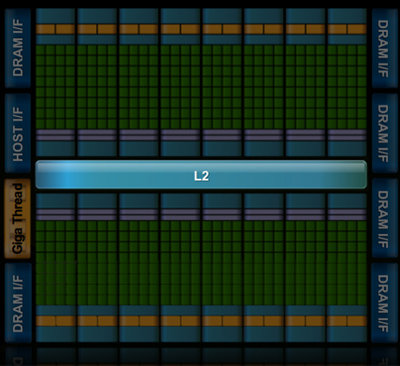

В распоряжении каждого SM GT200 было 16 Кб разделяемой памяти. Тем не менее, как кэш, в прямом смысле этого слова, данный массив функционировать не мог. Это была скорее программно управляемая память. В GF100 объем этого буфера вырос до 64 Кб, и теперь это можно назвать реальным L1 кэшем. Для того чтобы сохранить совместимость с приложениями CUDA, написанными для G80/GT200, эта 64 Кб память может быть сконфигурирована как 16/48 Кб или 48/16 Кб разделяемой памяти/L1 кэш. Помимо того, нетронутым остался и 12 Кб L1 кэш текстур, который был по большому счету бесполезен для программ CUDA. Наконец, все четыре GPC имеют доступ к общему 768 Кб L2.

Теперь в каждом SM находится по четыре текстурных блока, каждый из которых способен за один такт вычислить 1 текстурный адрес и подготовить данные для 4 текстурных выборок. То есть по возможностям выборки GF100 превосходит GT200, но по адресации — уступает. Частота работы всех текстурных модулей соответствует 1/2 шейдерного домена, а не базовой частоте ядра.

|

Сравнение архитектур NVIDIA

|

G80

|

G92

|

GT200

|

GF100L*

|

GF100*

|

|

Потоковых процессоров на (SP) в TPC/GPC

|

16

|

16

|

24

|

128

|

128

|

|

Блоки текстурной адресации в TPC/GPC

|

4

|

8

|

8

|

16

|

16

|

|

Блоки текстурной фильтрации в TPC/GPC

|

8

|

8

|

8

|

64

|

64

|

|

Всего SP

|

128

|

128

|

240

|

480

|

512

|

|

Всего блоков текстурной адресации

|

32

|

64

|

80

|

60

|

64

|

|

Всего блоков текстурной фильтрации

|

64

|

64

|

80

|

240

|

256

|

* Условное обозначение GF100L соответствует GTX 480, так как полноценный GF100 пока что не представлен

Наконец, последние по списку, но не по значению, — ROP. Они были также реорганизованы, теперь 48 модулей разбиты по 8 единиц в 6 групп, к каждой из которых подведен 64-битный канал памяти. Отныне ROP имеют доступ к общему L2 кэшу GF100, тогда как в GT200 они обладали собственным кэшем второго уровня. Каждый ROP обсчитывает 1x стандартный 32-битный пиксель за такт, 1x FP16 пиксель за 2 такта, или же 1x точку FP32 точности за 4 такта. То есть возможна обработка 48 обычных пикселей за такт. Частота работы ROP равняется таковой у общего L2.

[N6-Нити и планирование задач]

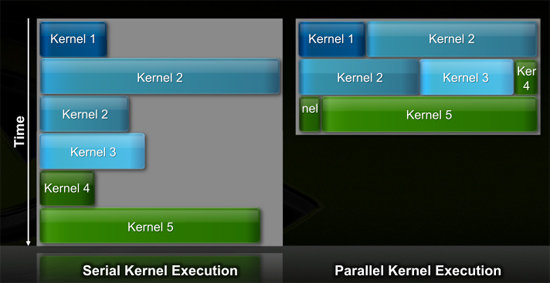

Тогда как NVIDIA G80 мог выполнять общие вычисления вследствие своей скалярной архитектуры, и это рассматривалась как дополнительный вариант применения GPU, GF100/Fermi проектировался с оглядкой на иные приоритеты. Реализации прошлых архитектур предполагали, что все SM чипа должны работать над одной и той же задачей (функцией, программой, циклом) в определенный момент времени. Если задача была недостаточно хорошо распараллеливаема, чтобы загрузить работой все имеющиеся в наличии ядра, то они банально простаивали, а эффективность чипа в результате падала. Так что говорить о высоком КПД унифицированной архитектуры возможно было лишь при условии работы с соответствующим ПО.

В новом поколении своей архитектуры, NVIDIA наделила планировщик задач новой функциональностью: теперь стало возможным параллельное исполнение нитей из разных задач. Это один из ключевых факторов, благодаря которым NV смогла увеличить количество SP в GF100, как минимум, без снижения эффективности их работы.

|

GT200 (слева) против GF100 (справа)

|

Было на порядок уменьшено время переключения контекста между режимами GPU и CUDA. Теперь эта задержка настолько незначительна, что возможно многократное переключение даже в пределах одного кадра. Это должно позволить более широко использовать PhysX.

С точки зрения работы с нитями, GT200 был настоящим монстром, способным на лету поддерживать до 30 000 потоков. Оказывается, данные показатели были даже избыточны. Бутылочным горлышком служила ПСП, а не возможность одновременного поддержания в работе такого количества нитей, так что в GF100 это число даже снизили до 24 тысяч.

|

|

GF100

|

GT200

|

G80

|

|

Количество одновременно поддерживаемых нитей

|

24576

|

30720

|

12288

|

NVIDIA совмещает 32 нити в одну группу, называемую "варпом" (warp). В GT200 и G80 половина подготовленного варпа передается в SM на каждый такт. То есть для передачи в SM всего набора из 32 нитей требуется два такта.

В прошлых архитектурах логика диспетчера SM была тесно связана с исполняющими модулями. Если какие-либо инструкции передавались на исполнение в SFU, весь SM ожидал окончания операции и не мог перейти к обработке следующих позиций в нитях. При этом если выполнение определенных команд предполагало использование одних только SFU, подавляющее большинство возможностей SM в GT200/G80 просто не использовались. Ясно, что это негативно влияло на общую эффективность.

В Fermi этот недостаток устранили. Теперь в чипе присутствует два независимых диспетчера на каждый SM. Эти блоки уже не связаны так тесно с внутренней структурой SM. Каждый из этих двух модулей может выбирать и отсылать на исполнение половину варпа за такт. При этом нити могут принадлежать различным варпам для как можно большего параллелизма и нахождения независимых операций. Логика распределения задач представлена двумя независимыми модулями одного уровня, они равноправно распоряжаются ресурсами внутри SM.

Недостаток решения NVIDIA состоит в том, что каждая нить в варпе должна исполнять одинаковую инструкцию в одно время. Если так происходит, то достигается полное использование ресурсов. Если нет, то некоторые модули простаивают.

Один SM может выполнять:

|

GF100

|

FP32

|

FP64

|

INT

|

SFU

|

LD/ST

|

|

Операций за такт

|

32

|

16

|

32

|

4

|

16

|

Если на исполнение запускается инструкция FP64, то весь SM может производить 16 операций за такт. Одновременное исполнение операций FP64 и SFU невозможно.

Хорошие новости состоят в том, что SFU теперь не привязан полностью ко всему SM. Один диспетчер может с легкостью послать 16 нитей соответствующему массиву ядер, тогда как второй — 16 нитей на SFU. По прошествии двух тактов диспетчеры могут вновь отправлять половины варпов. Сравните это с существовавшей ранее необходимостью ожидания всем SM полных 8 тактов после отправки нитей на SFU. Чувствуется, что на каждом уровне Fermi была проделана качественная работа по максимальному "развязыванию" и дроблению блоков. Остается проверить одно — как эта гибкость поможет GF100 в реальных приложениях.

[N7-Некоторые особенности: ECC и отсутствие NVIDIA Surround]

Еще один из моментов, о которых рассказывала NVIDIA на предварительных мероприятиях, посвященных выпуску Fermi, — поддержка режима коррекции ошибок ECC. Fermi предлагает ECC для своего регистрового файла, кэшей первого и второго уровней, а также набортной видеопамяти. Последнее особенно интересно в свете того, что при обычных обстоятельствах внедрение ECC сопряжено с необходимостью организации более широкой шины и установки дополнительных чипов памяти. Хотя в игровой серии GTX 400 данная технология и отключена, мы расскажем, как работает ECC на Fermi, так как подход NVIDIA интересен.

Так, для того чтобы организовать ECC на обычных модулях PC DIMM, необходимо 9 чипов на один канал (9 бит на байт), подключенных к 72-битной шине, вместо стандартных 8 чипов и 64-битного канала. Тем не менее, у NVIDIA не было ни желания, ни возможности добавить еще больше разрядности шине памяти и установить больше чипов GDDR5, не говоря уже о том, что 8 не делится без остатка на 10/12 каналов памяти. Так как же инженеры смогли воплотить ECC на имеющейся конфигурации?

На самом деле, принцип здесь довольно прост. Когда пользователь хочет активировать ECC, карта резервирует часть набортной памяти под контрольные суммы ECC. Таким образом, VRAM просто уменьшается на 1/8 (для имитации работы девятого бита), и данные ECC располагаются в этой зарезервированной области. Поэтому прочие дополнительные затраты не требуются. Согласитесь, изящный путь решения поставленной задачи с минимальными потерями!

С технической стороны, несмотря на нестандартную реализацию, NVIDIA использует обычные алгоритмы одинарной и двойной коррекции ошибок Single Error Correction / Double Error Detection (SECDED), поэтому вопрос о надежности технологии не стоит. При этом потеря производительности минимальна, даже ниже ожидаемых 12.5%. Каким образом удалось при фактическом сокращении пропускной способности добиться таких результатов, NV не говорит, ссылаясь на специфические методы собственной разработки.

Переходя к более интересным для простого пользователя технологиям, упомянем о 3D Vision Surround, конкуренте Eyefinity, который демонстрировался NVIDIA на CES. На тот момент утверждалось, что эта дополнительная возможность будет доступна одновременно с запуском серии GTX 400, но, как и многое другое, связанное с Fermi, 3D Vision Surround запаздывает.

В последней доступной на момент тестирования версии драйверов не было никакого упоминания ни о 3D Vision Surround, ни о простом Surround. Ожидается, что эти возможности будут добавлены в 256 линейке ForceWare, выходящей в апреле. Но на сегодняшний день никаких комментариев по поводу качества работы данных технологий в реальных условиях мы дать не можем.

[N8-Тесселяция и PhysX]

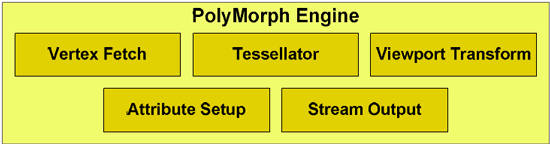

Детальное изучение производительности серии GTX 400 мы начнем с тесселяции и PhysX. Эти возможности у NVIDIA на особом счету. Именно из-за желания компании достичь высокой скорости аппаратной тесселяции было принято решение о создании выделенных PolyMorph Engine.

Соответствие DirectX 11 предполагает жесткие рамки реализуемых технологий, и NVIDIA стремилась превзойти AMD, не выходя за стандарты Microsoft. Тесселяция — один из моментов, в которых свободы действий было достаточно для этого. Чтобы достичь заметного преимущества, NVIDIA потребовалось реструктуризировать вычислительные блоки Fermi. В конечном счете, в чипе оказалось 14/15/16 тесселяторов (в зависимости от версии карты и числа активных SM), включенных в состав движков PME. В теории, обладая большей производительностью тесселяции, карты NVIDIA могут прорисовывать картинку более качественную, чем Radeon HD 5000, при этом от разработчиков требуется не слишком много для реализации потенциала GF100.

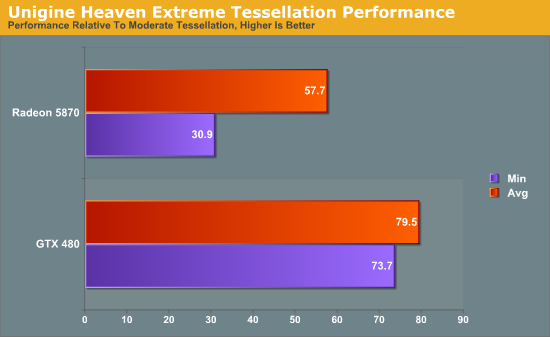

В качестве первого теста на производительность тесселяции был выбран Unigine Heaven 2.0, выпущенный всего пару недель назад. Во второй версии бенчмарка была добавлена возможность выбора уровней качества тесселяции (UH 1.0 заслужил славу чрезмерно нагружающего видеокарты), что позволит нам более полно оценить картину производительности при более и менее активном использовании тесселяции. Если способности GTX 480 в действительности настолько превосходят Radeon HD 5870, как утверждает NV, GF100 должен лучше справляться со сложными режимами UH 2.0.

Так как Heaven, по сути, является синтетическим тестом (на данный момент полноценных DX11 игр не существует), мы будем говорить об относительной производительности тестируемых плат, а не о полученных абсолютных показателях и количестве кадров в секунду.

|

|

|

Низкий (сверху), и максимальный (снизу) уровни тесселяции

|

Heaven предоставляет выбор между четырьмя уровнями тесселяции: выключена, низкая, средняя, максимальная. Чтобы показать разницу в качестве, мы провели тесты с низкой и максимальной детализацией. На диаграммах — процентные показатели скорости карт, работающих с максимальной тесселяцией, относительно более низкой планки.

Если говорить о средних величинах, GTX 480 удается сохранить 79% производительности при переходе от низкой детализации к максимальной. Падение скорости на Radeon 5870 более выражено и составляет целых 42%, т.е. остается лишь 58% от производительности в простом режиме.

Минимальный фреймрейт еще более показателен. Тогда как новинка NVIDIA теряет 26%, Radeon HD 5870 показывает на 69% худшие результаты. Отчетливо видно, что со сложной тесселяцией GTX 480 справляется существенно лучше 5870.

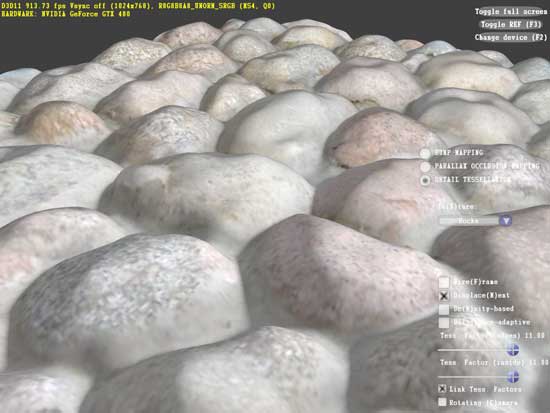

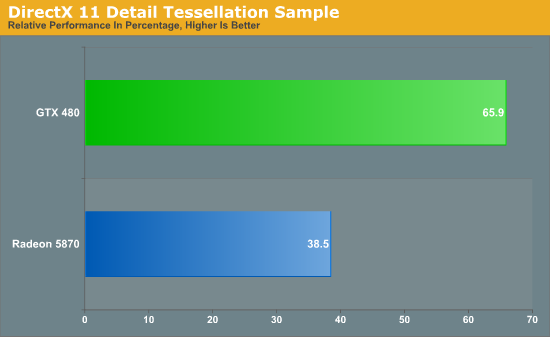

Вторым бенчмарком тесселяции выступила одна из демонстрационных программ Microsoft набора DX11: Detail Tessellation. Это сцена, в которой используется тесселяция и карты смещения, чтобы превратить плоскую текстуру скалы в реалистичную, сложную геометрически, модель. Здесь замерялось и сравнивалось между собой среднее количество кадров в секунду при двух уровнях качества (т.н. коэффициенты 7 и 11).

Полученные результаты только подтверждают увиденное нами ранее в Unigine. GTX 480 сохраняет 65% производительности при усложнении тесселяции, тогда как Radeon 5870 замедляется до 38%. Очевидно, что Fermi подвержен потери скорости от более сложных расчетов геометрии в куда меньшей степени, чем представитель линейки AMD Evergreen. Как показывают тесты, подход NVIDIA к организации тесселятора оказался более удачным, этот модуль заметно выигрывает в скорости работы у Cypress.

Однако сама по себе более мощная реализация аппаратной тесселяции ничего не означает. Применение данной технологии как таковой целиком и полностью зависит от разработчиков игр, в их же власти дать пользователям вручную выбирать и уровни качества тесселяции. На сегодня все игры, в той или иной мере использующие DX11, используют тесселяцию довольно ограниченно, поэтому дополнительные способности GTX 400 просто не используются. Конечно, это не означает, что так будет продолжаться всегда, но полагаться на только ожидаемые изменения в будущем — всегда рискованно.

Превосходные возможности тесселятора NVIDIA требуют от разработчиков внедрения нескольких уровней качества тесселяции. Ведь необходимо обеспечить высокую производительность не только на GF100, но и на менее скоростных решениях AMD ценой некоторого упрощения геометрии. Как было отмечено выше, данные нововведения не слишком сложны и не меняют процесс разработки кардинально. Тем не менее, пока невозможно однозначно утверждать, будет ли производительность при тесселяции настоящим преимуществом GTX 400 в конкурентной борьбе с Radeon HD 5800, или же станет формальностью вроде DirectX 10.1 для HD 3800, удачной для рекламы, но малополезной в реальных приложениях. На сегодня мы не беремся рекомендовать GTX 480/470 к покупке исключительно из-за лучшей производительности новинок NVIDIA при тесселяции.

Следующей технологией, требующей отдельного рассмотрения, является PhysX. В 2008 году NVIDIA купила разработчика AGEIA вместе со всеми программными и аппаратными технологиями, воплотив физический движок PhysX в качестве CUDA приложения для запуска на своих GPU. Тем самым, отпала необходимость в покупке специализированной платы. С того момента компания различными способами убеждала пользователей и разработчиков в преимуществах данной технологии, однако успех этого продвижения вряд ли можно было назвать однозначным. Пожалуй, "звездный час" для PhysX настал лишь в прошлом году с выходом игры Batman: Arkham Asylum, превосходно оцененной прессой и игроками.

С заметно усовершенствованными вычислительными способностями Fermi, NVIDIA получила возможность говорить о лучшей производительности PhysX на новых картах, а, значит, и о потенциально более полном и частом использовании технологии для имитации сложных и реалистичных физических эффектов. К тому же, благодаря быстрому переключению контекста и поддержке конкурентных программ, накладные расходы PhysX на Fermi должны оказаться меньше, чем на GT200/G80.

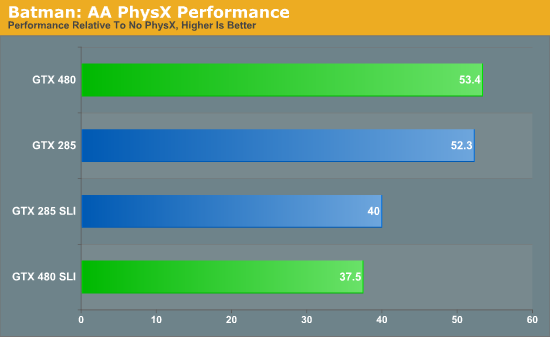

Чтобы проверить эти теоретические выкладки на практике, мы замерили производительность Batman: Arkham Asylum на картах разных поколений. Если PhysX на Fermi в действительности работает быстрее, чем на GT200, значит, количество кадров в секунду с включенным ускорением физики по сравнению с выключенным должно быть больше, чем на GTX 285. Тест был проведен в разрешении 2560x1600 при полностью отключенном PhysX, и установленном на высоком уровне качестве.

Если PhysX и работает на Fermi быстрее, чем на архитектурах-предшественницах, то Batman явно не из тех игр, где эта разница заметна. На обеих GTX 480 и GTX 285 относительное падение производительности при включении PhysX составило приблизительно 47%. Естественно, в абсолютных величинах GF100 оказался быстрее, но само замедление от активации аппаратного ускорения физики оказалось таким же, как и на флагмане предыдущего поколения. В SLI конфигурации плат дела также обстоят неважно: теряется порядка 60% скорости при включении PhysX на любой из пар карт.

Без сомнений, текущая реализация PhysX на GTX 480 требует таких же затрат, как и на GTX 285. Если и стоит ожидать каких-то серьезных улучшений, то либо от совершенно новой версии PhysX 3, либо от одной из обновленных веток PhysX 2.x. На имеющихся сегодня играх плюсов GF100 не замечено.

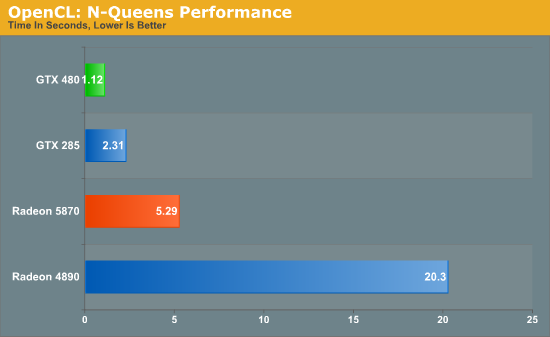

Второй тест призван дать более общее представление об уровне производительности PhysX. Мы использовали техническую демонстрацию NVIDIA Raging Rapids, которая изображает поток воды, а физика используется для реалистичного создания волн, водопадов и прочих явлений природы. На графике представлено количество FPS.

Полученные в Raging Rapids результаты оказались неоднозначными. С одной стороны, этот бенчмарк входит в число наиболее удачных для GTX 480; в нем виден существенный скачок в производительности по сравнению с GTX 285. По чистой скорости PhysX GF100 опережает GT200 более чем в два раза! С другой, если компенсировать увеличенное количество шейдерных процессоров Fermi более сложной симуляцией воды, преимущество составит лишь около 10% вместо линейного двукратного прироста. Это говорит об отличной масштабируемости, но превосходство GF100 обусловлено количественными характеристиками, а не качественными. Само по себе наличие удвоенного массива шейдерных процессоров однозначно положительно сказывается на производительности, но на архитектурном уровне вряд ли GTX 480 заметно превосходит GTX 285 в PhysX по удельной эффективности.

[N9-Вычислительные способности]

Перед тем, как перейти к самим тестам, необходимо сделать довольно значимую оговорку. Оказывается, в GTX 400 производительность FP64 операций искусственно занижена относительно аппаратных возможностей GPU (1/2 скорости FP32), и составляет 1/8 (12.5%). Это было сделано по маркетинговым соображениям для сегментации рынка. Как и ECC, быстрые расчеты FP64 доступны только в Tesla. На наших тестах это обстоятельство не сказывается, так как все они основаны на расчетах с FP32 точностью.

Продолжая исследование возможностей неграфических вычислений GF100, перейдем к более общим GPGPU задачам. Известно, что современные видеокарты с унифицированными шейдерными процессорами, обладая намного более простым устройством самих ядер по сравнению с CPU, могут значительно превосходить ЦП в хорошо распараллеливаемых задачах, где большое количество одновременно исполняемых потоков играет решающую роль. Серия GTX 400, будучи основанной на архитектуре Fermi, должна показывать прекрасную производительность в программах такого типа.

Но не стоит переоценивать важность данных расчетов. Хотя в специализированных задачах GPU с 480 потоковыми процессорами может показать себя настоящим монстром, существует не так много реальных домашних неигровых применений GF100. Безусловно, доступны кодировщики видео на CUDA, ПО для обработки фотографий и т.д., но, хотя прошло уже много времени с момента анонса технологии, этот сектор рынка развивается не очень динамично. Причем, виной тому и разрозненные несовместимые API. OpenCL и DirectCompute призваны решить данную проблему, но пока что стоит рассматривать GPGPU как приятное дополнение к впечатляющей графической производительности.

Когда OpenCL был представлен в прошлом году, мы надеялись, что к моменту запуска Fermi появятся подходящие для конечного пользователя приложения, которые помогут сравнить эффективность решений AMD и NVIDIA. К сожалению, этого не произошло, и в нашем распоряжении имеются лишь синтетические тесты для формального сравнения GPU. Мы зафиксировали результаты карт в паре таких бенчмарков, но эти показатели стоит воспринимать реалистично — они недостаточно точно показывают скорость работы плат GeForce и Radeon, давая лишь условный ориентир.

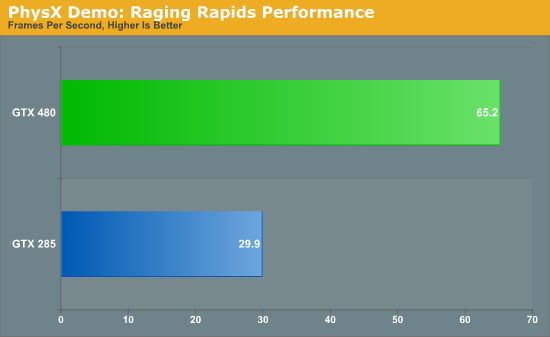

Начнем мы с OpenCL реализации N-Queens, разработанной PCChen с форумов Beyond3D. Этот бенчмарк использует инструменты OpenCL для нахождения решений известной шахматной задачи для доски заданного размера. Замеряется время проведения расчетов в секундах. В данном случае мы установили условный размер доски в 17x17 клеток и подождали, пока не будут найдены все доступные решения.

Этот тест отдает предпочтение GPU NVIDIA, карты серии GTX не просто оказываются в лидерах — GTX 285 даже победил с весомым преимуществом Radeon 5870. Из-за существенной разницы в организации шейдерных процессоров AMD и NVIDIA, даже с условно-унифицированным API вроде OpenCL от алгоритма запускаемой программы очень сильно зависит производительность. Поэтому, в зависимости от оптимизаций под конкретную архитектуру, можно добиться диаметрально-противоположных результатов. В любом случае, GTX 480 оказывается самым быстрым GPU из всех протестированных, вполовину опережая GTX 285, и в целых пять раз Radeon 5870.

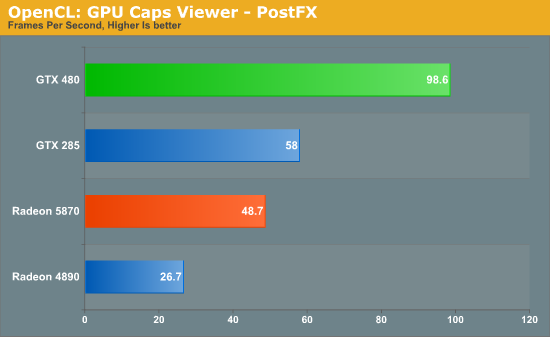

Вторым тестом был выбран пост-процессиноговый бенчмарк из утилиты GPU Caps Viewer. В ней силами OpenGL сначала рисуется тор, а затем на него накладываются различные эффекты с помощью OpenCL. На графике — фреймрейт данного процесса.

И снова изделия NVIDIA показали себя на высоте. Без сомнений, GTX 480 является победителем, а GTX 285 снова удается взять верх над обеими картами Radeon. Возможно, дело здесь вновь в оптимизациях алгоритма под архитектуру NVIDIA, хотя повторяемость результатов может указывать на то, что GeForce в действительности настолько превосходят Radeon HD в OpenCL. Но, пока реальных приложений, написанных на OpenCL нет, можно выстраивать сколько угодно догадок.

Перейдем от бенчмарков, запускающихся на всех GPU, к заточенным под CUDA. Эта технология присутствует на рынке больше времени, и, как следствие, лучше изучена разработчиками. Под данную платформу даже написаны некоторые реально-используемые GPGPU программы. Но, так как CUDA работоспособна лишь на картах NVIDIA, сравнение с Radeon провести не получится. Зато будет интересно посмотреть, насколько GTX 480 быстрее GTX 285.

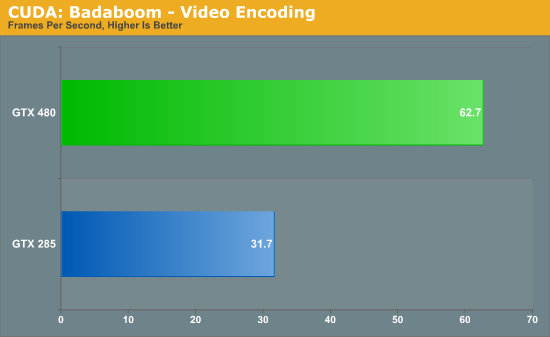

Мы начнем с Badaboom — известного кодировщика видео, написанного Elemental Technologies специально для CUDA. С его помощью сжимался двухминутный 1080i ролик. Единицей измерения же служит количество обрабатываемых в секунду кадров.

Разница в производительности в Badaboom впечатляет, но не является чем-то удивительным. Ведь у GTX 480 в распоряжении вдове больше потоковых процессоров, работающих на примерно тех же самых частотах, что и GTX 285. Как следствие, пропорционально возрастает и производительность.

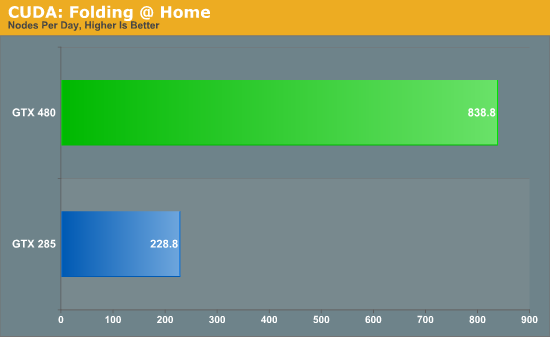

Следующим тестом стала специализированная версия Folding@Home для измерения производительности GPU, в которую как раз добавили совместимость с Fermi. Folding@Home — всемирный проект Стэндфордского Университета, направленный на изучение процессов синтеза белка. Вычисления носят характер распределенных, а поддержка видеокарт была добавлена еще в 2006 году в серии ATI X1K. В нашем случае замерялось полное время окончания расчетов над отдельно взятой задачей. Это позволило рассчитать, сколько пакетов задач (nodes) удастся выполнить за целый день работы Folding@Home.

Пожалуй, Folding@Home является первым бенчмарком, в котором мы можем наблюдать весь потенциал вычислительной мощности Fermi. В отличие от предыдущих тестов, где в лучшем случае достигался двукратный прирост производительности относительно GTX 285, в F@H новый чип был в несколько раз быстрее. За одно и тоже время GF100 способен выполнить до 3.5 раз больше работы, чем GT200. И, хотя Folding@Home является скорее научным приложением, не приносящим реальной пользы обычным домашним пользователям (не затрагивая медицинское применение результатов, конечно), оно дает представление о реальных способностях Fermi в вычислениях.

Наконец, задействуем еще одну техническую демонстрацию NVIDIA, носящую название Design Garage. Это одно из немногих доступных сегодня реально работающих приложений, которые строят изображение методом трассировки лучей. Именно его показывали ранее на CES. Последнее время о ray-tracing технологиях говорят все больше, и не последнюю роль в их популяризации сыграла Intel со своим проектом Larrabee. Но пока что все остается на стадии концептуального применения, и скорости прорисовки графики в реальном времени даже у GTX 480 не хватает. Для обеспечения привычной по современному 3D детализации с приемлемой скоростью потребуется еще несколько лет. Хотя определенные сдвиги в данном направлении происходят.

В Design Garage создаются и красиво подсвечиваются модели автомобилей. Детализация находится на достаточно высоком уровне. Но, как видите, даже GF100 способен создавать лишь несколько кадров в секунду.

С другой стороны, довольно интересно, что NVIDIA вообще приняла решения ввязаться в гонку с Intel за первенство в освоении новой сферы. Видимо, компания считает данное направление перспективным, иначе ресурсы не тратились бы понапрасну.

Как и Folding@Home, DG показывает GTX 480 с лучшей стороны. По сравнению с GTX 285, GF100 оказывается в восемь раз быстрее! Такой впечатляющий отрыв возник в первую очередь благодаря новой структуре кэш-памяти чипа, так как для трассировки лучей критически важно наличие в кэше требуемых данных без необходимости обращений в видеопамять. Очевидно, прикладные программы, зависимые от конкурентных операций, быстрого переключения задач и скорости кэша могут выполняться на Fermi чуть ли не на порядок эффективнее, чем на GT200.

[N10-Качество изображения и AA]

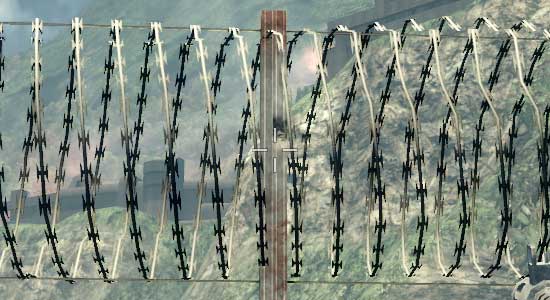

Когда речь заходит о качестве изображения, то наиболее важные усовершенствования, произведенные NVIDIA в Fermi, касаются сглаживания сложных поверхностей, которые изображают ненастоящую геометрию. Речь идет о таких объектах, как сетчатый забор или колючая проволока. Для того чтобы справляться с антиалиасингом подобных конструкций, в арсенале Fermi присутствует несколько новых инструментов.

Первый из них — возможность использования дополнительных выборок покрытия пикселя CSAA, что в паре с методом alpha-to-coverage позволяет очень качественно сглаживать текстуры. С дополнительными выборками, которые обеспечиваются CSAA в этом режиме, Fermi способен создавать большее число уровней полупрозрачности, чем решения прошлых поколений. Это должно значительно улучшать внешний вид создаваемых градиентных переходов.

Вторым является новый тип CSAA сглаживания, названный 32x. Такое число получается из суммы 8 полноценных мультисемплинговых выборок и 24 выборок покрытия пикселей. Все вместе это дает до 63 возможных уровней прозрачности при сглаживании "ненастоящей" геометрии с использованием alpha-to-coverage.

Однако на практике эти изменения не принесли ожидаемого эффекта. По полученной на CES информации можно было решить, что NVIDIA действительно значительно улучшила возможности антиалисинга текстур, имитирующих геометрические поверхности, причем новые техники еще должны были быть и несильно требовательны к ресурсам. Но в реальности лишь немногие игры действительно получают какие-то преимущества от данных нововведений; среди них можно назвать Age of Conan. Лучшим решением было бы массовое использование разработчиками DX10+ приложений самого метода alpha-to-coverage, чтобы все владельцы GPU, способных производить обычное сглаживание MSAA, получили возможность любоваться сглаженными текстурами. Но пока до этого еще далеко.

Это подводит нас к третьему, и самому интересному новшеству. Инженеры NVIDIA добавили новый режим Transparency Supersampling (TrSS) в Fermi (и, что довольно неожиданно, в GT240), который работоспособен там, где прошлую реализацию использовать было нельзя. Предыдущий TrSS работал только в играх с DX9 движком, а в DX10 выбор техник сглаживания текстур был невелик. Новый TrSS теперь поддерживает и DirectX 10.

Почему это так важно? Дело в том, что у многих DX10 игр большие сложности со сглаживанием "ненастоящих" геометрических поверхностей, причем этим страдают и популярные хиты. Например, в DX10 режиме Crysis сейчас не поддается сглаживанию листва, и даже в совсем новых играх вроде Battlefield: Bad Company 2 возникают схожие проблемы. Реализация TrSS GF100 полностью устраняет все эти недостатки.

|

Bad Company 2 DX11 без Transparency Supersampling

|

|

Bad Company 2 DX11 c Transparency Supersampling

|

Плохие новости заключаются в том, что этот режим пока еще не полнофункционален. Как вы можете видеть на представленных скриншотах, качество не вызывает никаких нареканий, но вот потеря производительности существенна. NVIDIA обещает, что уже в следующем месяце ситуация будет исправлена, и падение скорости будет сопоставимо с прошлой реализацией TrSS под DX9. Мы решили не ждать новых версий драйверов, и показать, как обстоит дело на текущий момент. Но помните, что, согласно обещаниям NV, уже совсем скоро производительность должна улучшиться.

Для просмотра полного скриншота нажмите на картинку.

|

NVIDIA GeForce GTX 480

|

NVIDIA GeForce GTX 285

|

ATI Radeon HD 5870

|

ATI Radeon HD 4890

|

|

0x

|

0x

|

0x

|

0x

|

|

2x

|

2x

|

2x

|

2x

|

|

4x

|

4x

|

4x

|

4x

|

|

8xQ

|

8xQ

|

8x

|

8x

|

|

16xQ

|

16xQ

|

DX9: 4x

|

DX9: 4x

|

|

32x

|

DX9: 4x

|

DX9: 4x + AAA

|

DX9: 4x + AAA

|

|

4x + TrSS 4x

|

DX9: 4x + TrSS

|

DX9: 4x + SSAA

|

|

|

DX9: 4x

|

|

|

|

|

DX9: 4x + TrSS

|

|

|

|

За исключением нового режима NVIDIA TrSS, изменилось не слишком многое. В DX10 все карты показывают |

Подождите...

Подождите...